Categoria: Tecnologia

Europa ed AI

Ai Act, sulle regole per l’intelligenza artificiale raggiunto l’accordo in Europa. Breton: “Momento storico, guideremo la corsa”

Disposizioni vincolanti su trasparenza e sicurezza per i grandi modelli come quelli di Google e OpenAI. Il riconoscimento facciale possibile solo per reati gravi e con autorizzazione del giudice. La norma entrerà in vigore progressivamente nell’arco di due anni, ma le incognite sulla sua efficacia restano

Repubblica – di Filippo Santelli

09 DICEMBRE 2023

L’Unione europea avrà una pionieristica legislazione sull’Intelligenza artificiale, la più completa ed organica al mondo, con l’obiettivo di coniugarne lo sviluppo con il rispetto dei diritti fondamentali. Sabato notte – dopo 36 ore di negoziato finale condotto nell’arco di tre giorni – l’Europarlamento, la Commissione e il Consiglio hanno trovato un accordo politico sull’AI Act. Il testo finale andrà ancora limato nelle prossime settimane, ma l’intesa assicura che sarà approvato entro la fine della legislatura europea, per poi entrare progressivamente in vigore nei successivi due anni. Un risultato non scontato, considerate le distanze con cui da un lato il Parlamento, più attento alla protezione dei diritti, e dall’altro i governi, più attenti alle ragioni dello sviluppo economico e dell’ordine pubblico, si erano presentati a questo ultimo appuntamento negoziale. Lo scoglio sulla regolamentazione delle Intelligenze artificiali più potenti, come quelle sviluppate dai colossi OpenAi, Meta e Google, era stata superato giovedì: saranno sottoposte a regole vincolanti su trasparenza e sicurezza, non solo a codici di condotta volontari. Ieri poi si è trovato un compromesso anche sull’ultimo, l’utilizzo delle applicazioni di AI nei contesti di polizia: resta ammesso il riconoscimento biometrico, per citare uno dei temi più spinosi, ma solo in caso di reati gravi e previa autorizzazione di un giudice.

“E’ un momento storico”, ha esultato il Commissario europeo Thierry Breton, definendo l’AI Act una rampa di lancio che permetterà a ricercatori e aziende europee “di guidare la corsa globale all’AI”. “Questa legge assicura che i diritti e le libertà siano al centro dello sviluppo di questa tecnologia rivoluzionaria, garantendo un bilanciamento tra innovazione e protezione”, ha detto Brando Benifei, europarlamentare Pd e relatore della norma. Anche se le incognite sull’equilibrio finale, l’applicazione e l’efficacia dell’AI Act restano molte.

Emozioni, discriminazioni e supervisione umana

Il principio alla base dell’AI Act è la distinzione delle applicazioni dell’Intelligenza artificiale sulla base del livello di rischio che pongono per i diritti fondamentali. Una serie di ambiti giudicati troppo rischiosi sono quindi banditi: si tratta per esempio dei sistemi di “social scoring” (come quello teorizzato e sperimentato in Cina), o di quelli che manipolano comportamenti e decisioni. Gli algoritmi di riconoscimento delle emozioni vengono banditi da scuole e luoghi di lavoro, ma sembrerebbe restino utilizzabili in contesti di immigrazione e sicurezza, come chiedevano i governi. La spunta invece il Parlamento sui sistemi di categorizzazione basati su informazioni sensibili – razza, religione, orientamento sessuale -: saranno vietati.

C’è poi una lunga serie di applicazioni giudicate ad “alto rischio” e sono quelle che riguardano ambiti che toccano i diritti fondamentali come salute, lavoro, educazione, immigrazione, giustizia. Qui l’AI Act introduce una serie di prescrizioni per chi le sviluppa e per chi le utilizza, come per esempio una valutazione preliminare dell’impatto, anche per evitare i rischi – ben documentato – di errori o discriminazioni, la necessità di una supervisione umana, quella di informare l’utilizzatore che sta interagendo con una macchina.

Riconoscimento facciale ed eccezioni per la polizia

Come detto, un punto molto dibattuto è stato l’utilizzo dei sistemi di riconoscimento biometrico. Il Parlamento – con l’appoggio di diverse organizzazioni per i diritti civili – aveva proposto un bando completo, mentre i governi volevano ampissime eccezioni per i contesti di sicurezza. Il compromesso è che potranno essere usati solo previa autorizzazione di un giudice e in circostanze ben definite. Quelli “ex post”, quindi su immagini registrate solo per cercare persone sospettate di crimini gravi, quelli in tempo reale solo per emergenze terroristiche, ricerca di vittime o di sospettati di crimini gravi. Le eccezioni per la polizia riguardano anche l’utilizzo di applicazioni alto rischio, che potranno essere impiegate anche prima di aver ricevuto l’attestazione di conformità su autorizzazione di un giudice.

La legge non pone invece alcune limite all’utilizzo degli algoritmi nell’ambito della difesa e militare, che è esclusiva competenza degli Stati membri.

ChatGPT e i suoi fratelli

Rispetto al testo originario della Commissione, che risale a due anni fa, questo accordo aggiunge una serie di prescrizioni per le cosiddette General purpose AI, cioè grandi modelli così potenti da prestarsi a molteplici utilizzi. E’ il caso di quello alla base di ChatGPT e di quelli sviluppati dagli altri big della Silicon Valley come Google o Meta. Queste prescrizioni saranno vincolanti: una vittoria del Parlamento, visto che i governi – in particolare Germania, Francia e Italia – avevano chiesto nei giorni scorsi di limitarsi a dei semplici codici di condotta, nel timore che una regolazione troppo stringente finisca per soffocare l’innovazione in Europa.

La norma su questi grandi modelli ha due livelli. Il primo, che si applica a tutti, prevede la pubblicazione di una lista dei materiali usati per l’addestramento degli algoritmi, strumento che in teoria dovrebbe aiutare i produttori di contenuti a difendere – o farsi riconoscere – i diritti d’autore, oltre all’obbligo di rendere riconoscibili – per contrastare truffe o disinformazione – tutti i contenuti prodotti all’AI. Il secondo livello si applicherà invece ai sistemi più potenti, quelli che pongono “rischi sistemici”, e prevede delle valutazioni di questi pericoli e delle strategie di mitigazione, oltre che l’obbligo di comunicare alla Commissione, che si doterà di un apposito AI Office, eventuali incidenti. Il mancato rispetto delle regole comporta multe che vanno dall’1,5 al 7% del fatturato globale delle aziende coinvolte.

Le incognite

Le disposizioni dell’AI Act, una volta approvato, entreranno in vigore in maniera progressiva: dopo sei mesi quelle sulle applicazioni proibite, dopo dodici quelle sui sistemi ad alto rischio e sui modelli più potenti, le ultime dopo due anni. Sono tempi che serviranno alla Commissione per stabilire i dettagli tecnici necessari all’implementazione e alle aziende per adattarsi, anche se nel frattempo saranno già incoraggiate ad adeguarsi volontariamente. Ma certo questo lungo periodo di avvio alimenta i dubbi di chi sostiene che per una legge sarà difficilissimo tenere il passo di una tecnologia che – grazie all’abilità degli ingegneri e ai miliardi investiti – evolve in modo esponenziale. E che più la normativa è dettagliata più rischia di essere inefficace. L’alternativa, d’altra parte, è non prevedere alcuna regola o affidarsi ai codici di condotta autonomamente elaborati dalle stesse aziende: un approccio che è quello adottato per ora in sede di G7 e anche negli Stati Uniti, ma che consegna a Big Tech il potere di autoregolarsi. L’Europa pensa che non basti.

L’altra incognita riguarda la possibilità che questa normativa finisca per danneggiare l’innovazione in Europa più che favorirla. L’idea, anche questa diffusa, è che l’arbitro – in questo caso la Ue – non vince mai. Ma i rischi posti dall’Intelligenza artificiale, enormi come le opportunità, fanno dire a tanti altri che un arbitro in questo caso è necessario. Con la speranza che un campo da gioco delimitato con chiarezza aiuti a far crescere fuoriclasse in grado di competere con quelli americani.

Pier Luigi Pisa Repubblica del 14 LUGLIO 2023

A Elon Musk non bastavano Tesla, Space X e Twitter. L’imprenditore, infatti, ha fondato una nuova azienda. Si chiama xAI e ha l’obiettivo di “comprendere la natura dell’universo” attraverso lo sviluppo dell’intelligenza artificiale. Sul sito della nuova creatura si legge che xAI «lavorerà attivamente con Twitter, Tesla e altre compagnie per raggiungere la sua missione». Il team di xAI è guidato proprio da Musk e include undici persone – tutti uomini – che hanno lavorato in passato in grandi compagnie che sviluppano AI: OpenAI, Google Research, Microsoft Research, and DeepMind.

Il supervisore di xAI è Dan Hendrycks, che attualmente ricopre il ruolo di direttore del Centre for AI Safety. Quest’ultima è un’associazione non profit di San Francisco che ha pubblicato, recentemente, una breve lettera apocalittica in cui si paragonano i rischi derivanti dall’AI a quelli legati ad armi nucleari e pandemie. E si ipotizza l’estinzione dell’umanità se l’intelligenza artificiale non sarà opportunamente regolamentata.

L’azienda con cui Musk lancia la sua sfida a OpenAI, di cui tra l’altro risulta tra i fondatori, arriva in un momento particolarmente delicato per ChatGpt. I suoi utenti, per la prima volta da quando è stata lanciata l’intelligenza artificiale generativa di OpenAI, sono in calo. A giugno scorso – stando ai dati Similarweb – il traffico da mobile e da computer è diminuito del 9,7%. Eppure i suoi server sembrano sempre più affollati. Anche gli abbonati, che in teoria dovrebbero avere una corsia preferenziale, negli ultimi giorni hanno fatto fatica ad accedere. Non l’hanno presa bene. Per la versione “Plus” pagano 20 dollari al mese. In Italia, con le tasse, diventano 24. Può essere un buon motivo per andarsene.

Le alternative ormai sono numerose. Molte di queste gratuite. C’è Bing di Microsoft, che tra l’altro usa proprio l’AI di ChatGpt per generare le sue risposte. E c’è Bard di Google, finalmente disponibile anche in Italia. Ma la soluzione più interessante è Claude, il modello di intelligenza artificiale generativa sviluppato da due fratelli italoamericani: Dario e Daniela Amodei. Insieme hanno fondato Anthropic, un’azienda che sviluppa AI senza cercare unicamente il profitto, come fa ChatGpt. La loro è una Public Benefit Corporation, impresa che oltre agli utili insegue – come definisce il suo statuto – anche benefici per la società. Dario e Daniela vogliono fare molto di più. Intendono proteggerla. Dai potenziali rischi legati alla crescita incontrollata dell’intelligenza artificiale. I fratelli Amodei non hanno firmato appelli inconcludenti per “fermarla”, come ha fatto Elon Musk. Piuttosto, hanno lavorato a una soluzione.

Claude risponde a una raccolta di regole che Anthropic ha chiamato la “Costituzione dell’AI”. «Stiamo sperimentando metodi per addestrare una AI innocua che non richieda l’intervento dell’uomo», si legge sul sito di Anthropic. L’obiettivo è fare in modo che Claude sorvegli da sola le risposte che genera. Basandosi unicamente sull’elenco di princìpi fornito dai suoi ideatori. Proprio come i robot dei racconti di Asimov rispondevano alle tre leggi della robotica. L’intento è identico: non arrecare danni agli esseri umani. «Preferiamo che la nostra AI fornisca le sue risposte sulla base di valori determinati da una Costituzione – dice Anthropic – e non su quelli che scaturiscono dai feedback degli utenti su larga scala». E dunque Claude – per ora disponibile negli Usa e nel Regno Unito, ma presto anche in Italia – si basa su regole precise e soprattutto trasparenti, pubblicate sul sito di Anthropic e che si ispirano, tra le altre cose, ai princìpi provenienti dalla Dichiarazione universale dei diritti umani e a quelli dei “termini di servizio” di Apple. Uno di questi rispecchia, in effetti, l’attenzione alla privacy dell’azienda di Cupertino: «Scegli la risposta che contiene meno informazioni personali, private o riservate appartenenti ad altri».

Tutto questo non rende l’AI di Anthropic necessariamente “migliore” di ChatGpt. Claude, come la creatura di OpenAI, pare soffrire di allucinazioni. Un giornalista del Guardian le ha chiesto chi avesse vinto l’ultima Conference League e l’AI ha risposto «As Roma», che aveva vinto l’anno scorso, invece di «West Ham» (vincitore quest’anno). Abbiamo fatto la stessa prova e Claude ci ha detto che «la finale di Conference non è stata ancora giocata», mostrando limiti temporali alla sua conoscenza. L’AI di Anthropic ha lo stesso problema di ChatGpt, insomma, per cui è come se il mondo si fosse fermato a qualche tempo fa.

Eppure Claude, giunta in questi giorni alla sua seconda versione, e aperta finalmente al pubblico dopo un periodo di test riservato alle aziende, offre qualcosa di inedito nel panorama delle AI generative: può gestire testi molto lunghi, contenenti fino a 75mila parole. ChatGpt, invece, può analizzare fino a un massimo 3.000 parole. Ma per Dario e Daniela Amodei, che hanno lavorato in OpenAI per cinque anni prima di fondarne una che oggi vale 4,1 miliardi di dollari, la differenza principale è un’altra: «Claude tenda a dare risposte meno nocive. È più gentile, sembra davvero di parlare con un umano».

Pier Luigi Pisa Repubblica del 14 LUGLIO 2023

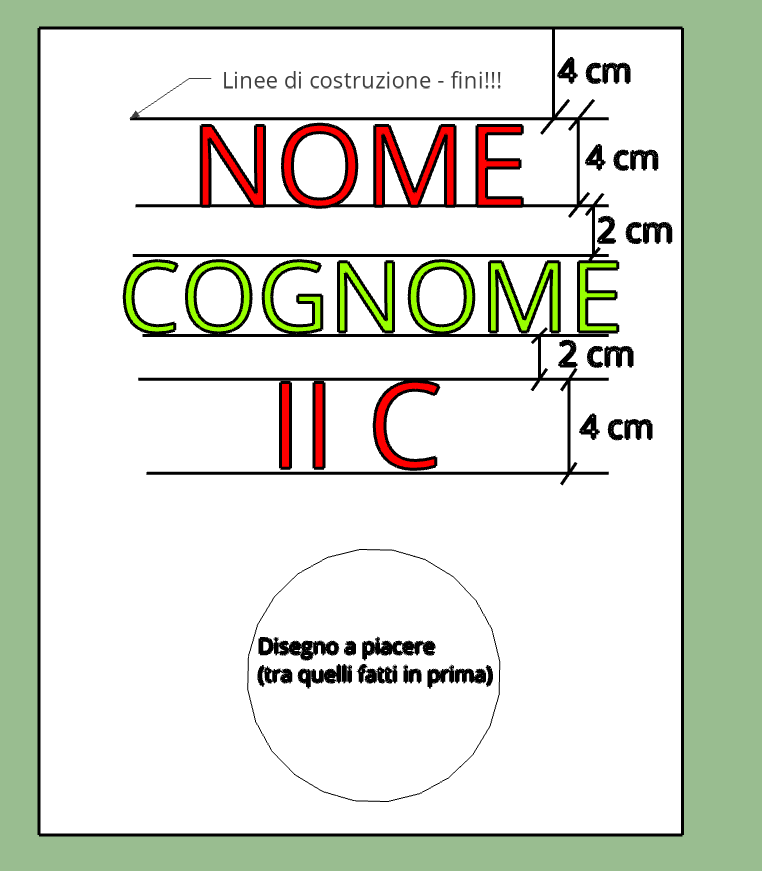

Verifica Google documenti

Materiale per il disegno tecnico

Ho visto il futuro del lavoro. La buona notizia è che i robot non prenderanno il nostro posto. Quella cattiva è che non stiamo facendo abbastanza affinché ciò accada. Le due notizie sono contenute nel più atteso rapporto in materia: The Future of Work, frutto di due anni di lavoro di una task force di economisti e tecnologi del MIT di Boston.

La missione era complicata e importante: trovare una risposta non emotiva, e quindi basata sui dati, sugli effetti della rivoluzione industriale in corso, quella digitale.

Nel 2013 uno studio dell’università di Oxford aveva concluso che quasi la metà di tutti i mestieri era a rischio di automazione: praticamente gli unici al sicuro erano il prete e il dentista. Poi si era scoperto che anche la santa messa e la confessione si potevano impartire via web, e molti hanno iniziato ad alzare le barricate: vade retro robot. Comprensibile. Ma anche sensato?

Il rapporto del MIT (92 pagine e alcuni grafici molto interessanti) afferma definitivamente di no. Quelli che parlano di una imminente, inevitabile “fine del lavoro” dicono una cosa smentita dai fatti: negli ultimi 130 anni negli Stati Uniti il numero di persone al lavoro è aumentato sempre; è aumentato al tempo della meccanizzazione, e adesso, con l’automazione dei robot e del digitale. Ma se l’automazione consente ad un software di “risparmiare lavoro”, come fa il lavoro ad aumentare? Per diversi fattori legati alla produttività e alla crescita dell’economia, ma forse il più importante è la creazione di nuovi, diversi, posti di lavoro. La maggior parte dei lavori che facciamo oggi nel 1940 neanche esistevano: il settore dei computer, delle energie rinnovabili, la televisione di massa, semplicemente non esistevano e neppure i relativi mestieri. Epperò se il saldo finale è positivo, la transizione va gestita: perché ci sono interi settori che hanno perso occupati – tipo l’agricoltura prima, le fabbriche poi -; e perché l’automazione tende a polarizzare i salari, vuol dire che guadagnano di più quelli che hanno in tasca una laurea o un master, che dirigono i robot; di meno tutti gli altri, che invece prendono ordini da un software (tipo i fattorini di Amazon).

La gestione di questa transizione spetta alla politica che ha due compiti fondamentali: difendere il lavoro esistente ma senza frenare l’innovazione; e impegnarsi ad aggiornare le competenze di chi ha un lavoro e di chi lo cerca. Ma questa è la brutta notizia: la verità è che non stiamo facendo abbastanza.

[Riccardo Luna da Repubblica del 25 Novembre 2020]